4/5 BIG DATA and MACHINE LEARNING GCP

4/5 – A Jornada Transformadora do Google Cloud: Da Necessidade à Inovação em Big Data e Aprendizado de Máquina

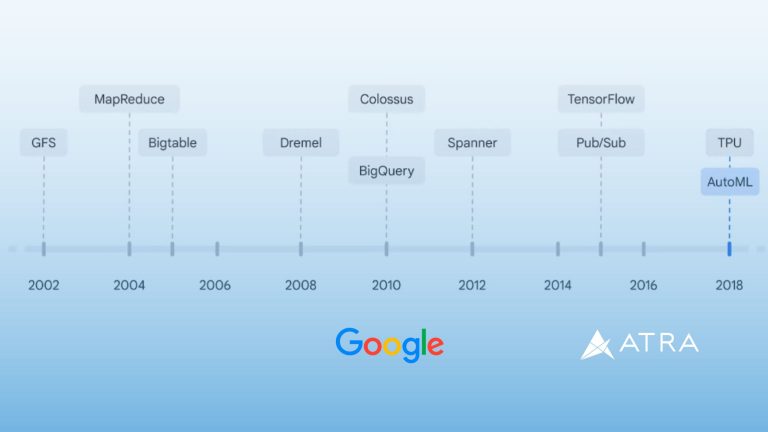

Desbravando os Desafios Iniciais (2002-2004)

Nos primeiros anos do Google Cloud, a crescente complexidade da web trouxe consigo desafios significativos no processamento de grandes volumes de dados. Em resposta, em 2002, surgiu o Google File System (GFS), uma infraestrutura robusta que se tornou a base para o armazenamento em nuvem.

Este foi um marco crucial que sinalizou a entrada do Google na era da computação em nuvem. Em 2004, o conceito revolucionário do MapReduce foi introduzido, abrindo caminho para uma abordagem inovadora no processamento em larga escala.

Da Complexidade da Web ao Cloud Bigtable (2005-2007)

À medida que a internet crescia exponencialmente, surgiram novos desafios, especialmente na manipulação de dados de streaming em tempo real. A resposta veio em 2005 com o lançamento do Cloud Bigtable, um serviço NoSQL de alto desempenho projetado para lidar com cargas de trabalho analíticas e operacionais.

O Cloud Bigtable se destacou ao enfrentar especificamente os desafios associados à gravação e recuperação de dados em tempo real, solidificando ainda mais a presença do Google no cenário de big data.

A Revolução do BigQuery e Dremel (2008-2012)

Em 2008, o Google deu um passo ousado com o lançamento da Dremel, uma solução inovadora para otimizar consultas em grandes conjuntos de dados. Essa tecnologia foi posteriormente incorporada ao BigQuery, transformando-o em um data warehouse gerenciado e sem servidor.

O BigQuery proporcionou uma capacidade sem precedentes de análise escalável sobre petabytes de dados com suporte a consultas SQL. Essa fase marcou um ponto de virada significativo na capacidade do Google de oferecer soluções analíticas avançadas na nuvem.

Colossus e BigQuery: Escalando Alturas em 2010

A década de 2010 trouxe consigo avanços notáveis. Em 2010, o Google lançou Colossus, um sistema de arquivos em nível de cluster que sucedeu o GFS. No mesmo ano, o BigQuery se destacou como um data warehouse totalmente gerenciado, consolidando ainda mais a posição do Google no cenário de big data.

A capacidade de realizar análises em larga escala sobre dados complexos tornou-se mais acessível, transformando a forma como as organizações abordavam o processamento de dados na nuvem.

Spanner, Pub/Sub e TensorFlow (2012-2015)

A partir de 2012, o Google introduziu o Spanner, um banco de dados relacional globalmente escalável, reforçando sua oferta de armazenamento de dados. Em 2015, o serviço Pub/Sub emergiu como uma peça-chave para análise de streaming e integração de dados.

Ao mesmo tempo, o TensorFlow foi lançado como uma biblioteca de código aberto, tornando-se um pilar central no ecossistema de aprendizado de máquina e inteligência artificial.

O Ano de 2018: TPU e AutoML

O ano de 2018 marcou outro ponto alto com o lançamento do Tensor Processing Unit (TPU), apresentando hardware especializado para acelerar tarefas de aprendizado de máquina.

Simultaneamente, o AutoML simplificou significativamente o processo de criação de modelos de ML, democratizando o acesso à capacidade de aprendizado de máquina.

Vertex AI: A Consolidação da Inovação (2021)

A culminação dessa evolução aconteceu em 2021 com o lançamento da Vertex AI, uma plataforma unificada de aprendizado de máquina. A Vertex AI consolidou diversas tecnologias e abordagens, proporcionando uma experiência abrangente e integrada para desenvolvedores e cientistas de dados.

Impacto na Linha de Produtos e Além

Essas inovações não apenas transformaram a linha de produtos de big data e aprendizado de máquina, incluindo Cloud Storage, Dataproc, Cloud Bigtable, Dataflow, Firestore, Looker, Cloud Spanner, AutoML e Vertex AI, mas também influenciaram a forma como organizações em todo o mundo abordam e aproveitam o poder da computação em nuvem para suas operações diárias.

O Google Cloud continua liderando o caminho da inovação, oferecendo soluções poderosas para os desafios complexos do processamento e análise de dados em larga escala.

Artigo criado por: Lucas de Sá

Fonte: Google Cloud